Comentamos en el post La base neuronal de la consciencia primaria la hipótesis del núcleo dinámico y los miles de millones de estados que discrimina, producidos por cientos de miles de sistemas especialistas. Esta alta densidad de informaciones, significados, connotaciones, y sus emociones asociadas, que una experiencia consciente contiene podría ser el origen de una propiedad fundamental de los qualia o experiencias subjetivas que acompañan a la consciencia: la sensación de barroquismo y de experiencia única y privilegiada que acompañan casi siempre a las escenas conscientes.

Las neuronas de la capa V de un área motora o premotora que participan en el núcleo dinámico pueden funcionar como puertos de salida activando las motoneuronas de la espina dorsal, pero estas motoneuronas con las que interactúan no deben considerarse parte del núcleo simplemente porque la interacción es de sentido único. El disparo de las motoneuronas no producen ningún cambio directo en el núcleo dinámico. Solamente las consecuencias de su comportamiento coordinado, en forma de contracciones musculares, podrán ser notadas sensorialmente, y estas impresiones llegar al núcleo consciente, pero tal influencia no es una reentrada directa entre las motoneuronas y el núcleo (Edelman y Tononi, 2000).

FIG Seis capas del córtex

La retina y otras neuronas del sistema visual primario tienen una actividad notable antes de que las neuronas corticales que señalan la presencia del color rojo se disparen. Estas neuronas corticales pueden considerarse puertos de entrada al núcleo. Su disparo produce efectos en amplias regiones del núcleo, cosa que no consiguen producir las neuronas del sistema visual primario, que producen efectos únicamente locales.

Hay puertos que son a la vez de entrada y salida. Por ejemplo, cuando queremos decir algo, no sabemos qué palabras vamos a usar, pero ellas surgen automáticamente con el significado correcto a medida que vamos necesitándolas, sin que tengamos que buscarlas y chequear su sintaxis conscientemente a cada paso. Y al ofrecer su producto al núcleo en el puerto (ahora de entrada), ayudan a que el núcleo avance hasta el siguiente estado consciente.

Los largos bucles paralelos unidireccionales que se encuentran en los ganglios basales (y en el cerebelo) tienen la arquitectura que uno imaginaría para implementar una variedad de rutinas y subrutinas neuronales inconscientes independientes: son activadas por el núcleo en puertos específicos; hacen su trabajo de manera rápida y eficiente pero de manera local y funcionalmente aislada; y en puertos específicos de entrada, proporcionan al núcleo los resultados de su activación. Hay evidencias de que los ganglios basales no sólo realizan rutinas motoras, sino que pueden dedicarse a distintas actividades (habla, pensamiento, planificación, etc.) dependiendo del área del cerebro donde esté el puerto de entrada.

FIG. Cuatro áreas donde se localizan los ganglios (o núcleos) basales: cuerpo estriado, globo pálido, sustancia negra y núcleo subtalámico

Debido a sus enormes capacidades asociativas, el núcleo dinámico estaría en una posición ideal para organizar jerárquicamente una serie de rutinas inconscientes preexistentes en una secuencia particular. Esto es lo que sucede cuando un pianista vincula deliberadamente pasajes de arpegio separados. El músico activaría estas rutinas desde su memoria, o a partir de la partitura.

Nuestra vida cognitiva generalmente está constituida por una secuencia continua de estados del núcleo que desencadenan ciertas rutinas inconscientes, que, a su vez, desencadenan ciertos otros estados del núcleo y así sucesivamente en una serie de ciclos. Al mismo tiempo, por supuesto, como en la interpretación de un músico, los estados del núcleo también se modifican por la entrada sensorial (que actúa en otros puertos), así como por la dinámica intrínseca del propio núcleo.

En una segunda fase, el enlace consciente entre distintas subrutinas que resulta útil o satisfactorio al núcleo consciente es reforzado hasta volverse inconsciente. La evidencia reciente indica que la selección neuronal que conduce al aislamiento funcional de circuitos especializados ocurre a través del refuerzo de los circuitos de los ganglios basales provocados por la activación de los sistemas de valoración, especialmente el llamado sistema dopaminérgico (llamado así por el neuromodulador dopamina que libera). Se ha demostrado que tales sistemas se activan cuando el comportamiento se ve reforzado por una recompensa y dejan de disparar una vez que se ha adquirido el comportamiento. El disparo del sistema dopaminérgico y de otros sistemas de valoración que inervan tanto los ganglios basales como las regiones corticales a las que ellos se proyectan puede ser el mecanismo clave para fortalecer los vínculos sinápticos que se forjan entre diferentes rutinas a través de la mediación del núcleo. De esta manera, los mapeos globales que están relacionados con una tarea en particular se pueden construir o vincular, durante el aprendizaje guiado conscientemente, hasta que un bucle sensorimotor sin discontinuidades se ejecuta de manera estable, rápida e inconsciente (Edelman y Tononi, 2000).

El desorden obsesivo-compulsivo puede ser entendido como una condición en la que ciertas rutinas motoras y cognitivas son disparadas con excesiva frecuencia, como si algunos puertos del núcleo estuvieran patológicamente abiertos. Esto se percibe a nivel consciente como una especie de intrusión.

Ciertas partes del sistema tálamo-cortical podrían separarse del núcleo a través de conexiones estrechas, tipo puertas, y dejar así de pertenecer a la experiencia consciente. Este podría ser el caso en enfermedades como la ceguera histérica, donde el paciente no es consciente de estar viendo, pero esquiva automáticamente los obstáculos. Este pequeño sub-conjunto autónomo mantendría contacto con la periferia motora y con ciertas áreas visuales. Algo de este tipo tiene lugar claramente en las personas con los dos hemisferios desconectados quirúrgicamente, en las que dos agregados funcionales (uno en el hemisferio izquierdo, con consciencia primaria y auto-reflexiva; otro en el hemisferio derecho, sólo con consciencia primaria) parecen coexistir en el mismo cerebro.

¿Es posible que tales circuitos talamocorticales activos pero funcionalmente aislados puedan ser la base de ciertos aspectos del inconsciente psicológico, aspectos que, como señaló Sigmund Freud, comparten muchas de las características de lo «mental», excepto que no lo hacen dentro de la consciencia? ¿pueden tales circuitos ser creados por mecanismos de represión? ¿pueden tales islas activas ser capaces de disparar sus propias rutinas en los ganglios basales, explicando así actos fallidos, acciones equivocadas, y similares? El tema merece ser investigado, según Edelman y Tononi.

Las neuronas espejo y la hipótesis de la mente en uno y en los otros

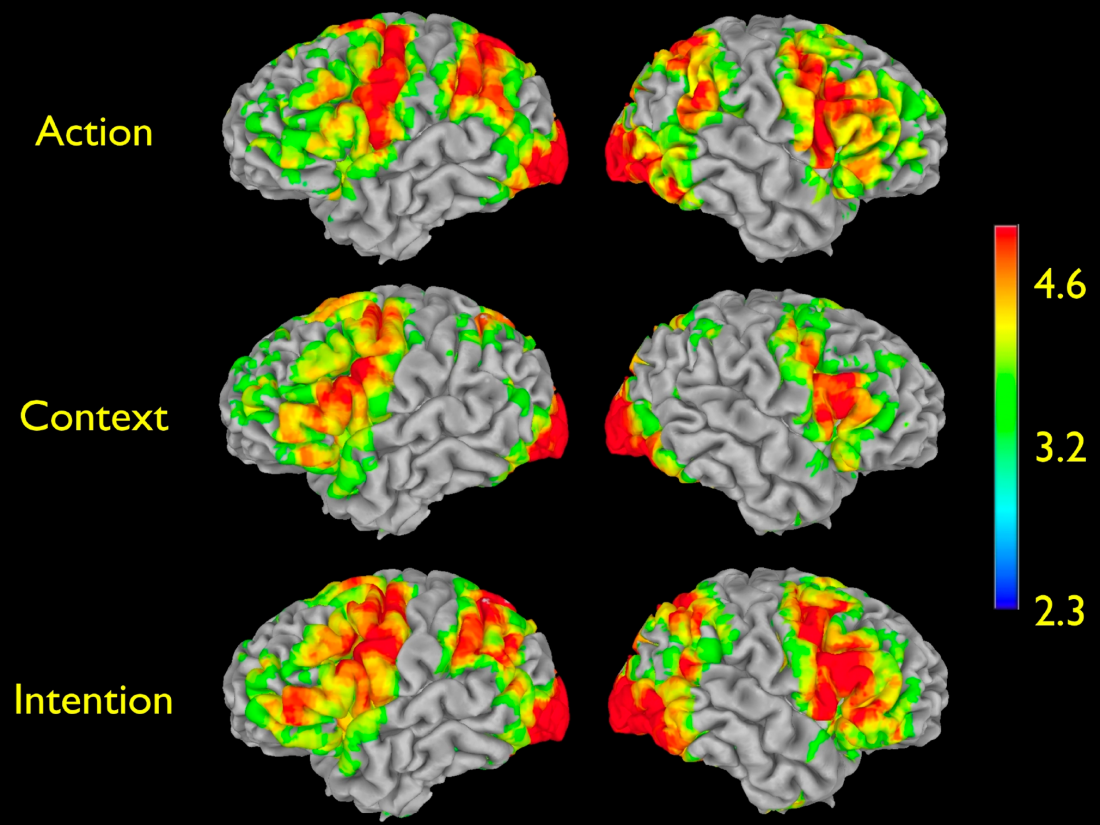

Las neuronas espejo se identificaron originalmente en los lóbulos frontales de los monos (en una región homóloga al área de lenguaje de Broca en los humanos). Se observó que esta clase de neuronas se disparan cuando el mono alcanza un objeto o simplemente mira a otro mono comenzar a hacer lo mismo, lo cual se podría interpretar como una forma de simular las intenciones del otro mono o de “interpretar su mente”. También se han encontrado neuronas espejo para el tacto; se disparan en una persona cuando la tocan y también cuando ve que otra persona es tocada. Se han encontrado neuronas espejo también en la ínsula, según Ramachandran (2011), para hacer y reconocer expresiones faciales, y en el arco cingulado anterior, para la «empatía» del dolor. No todas las neuronas de estos sistemas son neuronas espejo, sólo una parte de ellos.

Cuando un sujeto observa que otro es pinchado en la piel sus neuronas espejo sensoriales se activan, pero su reacción no llega a ser un dolor completo y una retirada del miembro, probablemente debido a las señales inhibidoras procedentes de la corteza frontal y también a las señales de normalidad procedentes de la propia piel.

El papel inhibidor de las señales de la propia piel parece coherente con la experiencia consciente de un paciente amputado con percibía una mano fantasma, estudiado por Ramachandran (2011). Cuando veía que la mano de otra persona era acariciada y atrapada, él sentía que le estaban haciendo lo mismo a su mano fantasma. Al no enviar la mano fantasma ninguna señal al cerebro, las neuronas espejo sensoriales de éste no serían inhibidas, y la sensación aparecería como propia y detallada en el sitio adecuado. Ramachandran llama “hiper-empatía adquirida” a este síndrome, que identificó también en otros tres pacientes suyos. Cuando los pacientes con este síntoma tienen dolores en la mano fantasma, sienten alivio viendo simplemente la mano de otra persona siendo masajeada. Notablemente, también se obtiene hiper-empatía cuando se anestesian los nervios que conectan el miembro con la espina dorsal (el plexo braquial).

La ventaja más evidente de tener neuronas espejos en distintas áreas sensoriales y motoras es que te permiten descubrir las intenciones de otra persona. Cuando ves que la mano de tu amigo Jose se mueve hacia la pelota, tus propias neuronas motoras asociadas a alcanzar la pelota comienzan a disparar. Al ejecutar esta simulación virtual de ser Jose, tienes la impresión inmediata de que tiene la intención de alcanzar la pelota. Esta capacidad crea así una teoría de la mente: el presupuesto de que en otros cuerpos ocurren los mismos fenómenos mentales que en el propio. Esta capacidad puede existir en los grandes simios en forma rudimentaria, pero los humanos somos excepcionalmente buenos en eso. Según Ramachandran, estas neuronas espejo pueden haber evolucionado en los humanos para tomar el punto de vista de otros no sólo visual, táctil o auditivo, sino también conceptual. Sería la perspectiva que invitamos a adoptar o tomamos cuando decimos: “míralo desde mi punto de vista”, o “veo lo que quieres decir”.

Otros síndromes disociativos

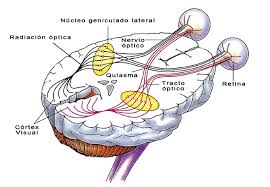

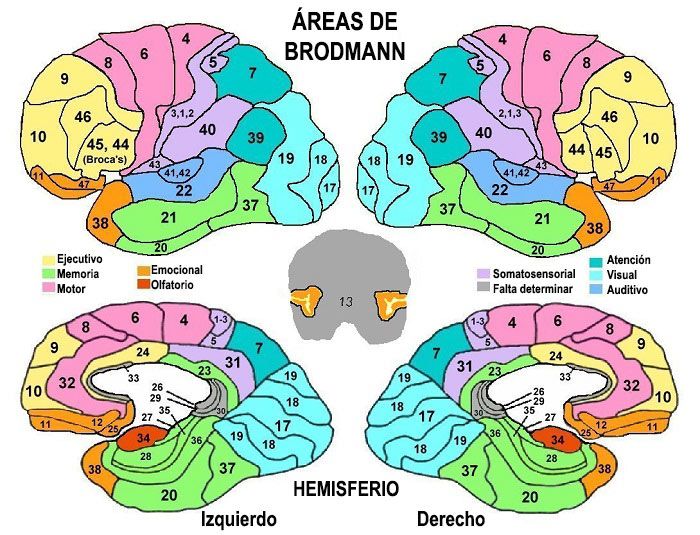

Vimos en el post Las bases neurológicas del reconocimiento de los cuerpos y la imitación que desde el punto de vista neurológico, hay dos caminos desde la retina hasta el área visual V1 del lóbulo parietal (área 17 de Brodmann). Uno (que Ramachandran llama el “camino antiguo”) pasa por el colículo superior y acaba en V1.

El otro camino (el “camino nuevo”) pasa por el núcleo geniculado lateral del tálamo, desde allí se dirige hasta V1, en el lóbulo occipital, y allí se bifurca en dos ramas: la rama del “donde” se dirige hacia el lóbulo parietal, y la rama del “qué” se dirige hacia el área 21 de Broadman, en el lóbulo temporal.

La primera rama está especializada en las relaciones espaciales entre los objetos identificados; la segunda, en las relaciones entre las propiedades encontradas dentro de cada objeto y lo que significan para uno, lo cual permitirá etiquetar posteriormente al objeto dentro de una categoría lingüística.

El camino “antiguo” puede dirigir la mano de una persona hacia un objeto en el campo visual de forma automática sin que la persona sea consciente de que está viendo el objeto. El camino “nuevo” permite, sin embargo, la experiencia consciente de estar viendo un objeto (Ramachandran 2011, Cap. 2).

La primera estructura de la ruta del “qué”, el giro fusiforme, parece clasificar el objeto visual en distintas categorías conceptuales (diferencia un pájaro de un humano, o un cuchillo de un piano) pero con poca elaboración sobre el significado del concepto para el observador. Pero cuando esta ruta se adentra más profundamente en los lóbulos temporales, evoca no sólo la categoría cruda sino un conjunto disperso de recuerdos asociados y hechos y usos del objeto, es decir, su significado para el observador. Esta recuperación semántica implica la activación de conexiones con otras áreas del lóbulo temporal, con el área lingüística de Wernicke y con el lóbulo parietal inferior, que está especializado en poner etiquetas lingüísticas (nombrar), escribir, y en la aritmética. Tras el apoyo de estas regiones, los mensajes se transmiten a la amígdala, que se encuentra incrustada en la punta frontal de los lóbulos temporales, donde evocan sentimientos relacionados con lo que (o quien) estás viendo (Ramachandran, 2011, Cap. 2).

Sin embargo, si el objeto visual tiene una alta saliencia (es inhabitual) el camino 2 no sigue esta ruta, sino que abrevia desde el giro fusiforme, pasando por surco temporal superior, hasta entrar directamente en la amígdala. De esta manera, evita pasar por las áreas que enriquecen el objeto visual con significaciones, y entra rápidamente en la amígdala, en el corazón emocional del cerebro, el sistema límbico. Este camino rápido evolucionó probablemente para promover reacciones rápidas ante escenas inhabituales, ya sean innatas o aprendidas. La amígdala trabaja junto con recuerdos que ayudan a calibrar la importancia emocional de la escena visual. Si la respuesta emocional de la amígdala es intensa (con emociones de hambre, miedo, odio o lujuria, por ejemplo), influye en el hipotálamo, que induce una liberación de las hormonas necesarias para preparar el sistema nervioso autónomo para una próxima acción (alimentarse, luchar, huir, cortejar, etc.). Esto incluye aumento del ritmo cardíaco, respiración rápida y superficial, y aumento de la transpiración (que aumenta la refrigeración del sistema motor). La amígdala está conectada también con los lóbulos frontales, que añaden matices a estas emociones primarias (v.g. arrogancia, prudencia, orgullo, admiración, magnanimidad, etc.).

Si el camino 3 que provoca las emociones resulta lesionado, pero el camino 2 del “qué” (que permite la identificación) permanece intacto, se produce un síndrome (de Capgras) en el cual el sujeto reconoce físicamente a la persona que tiene delante, por ejemplo a su madre, pero no siente por ella el menor afecto. Al ser esta disonancia intolerable para el cerebro consciente, el sujeto muchas veces racionaliza diciendo que la mujer presente es una “impostora” idéntica a su madre. Sin embargo, al hablar con ella por teléfono, sí que siente afecto por la que ahora sí reconoce como su madre. Esto se debe a que el camino que lleva al sistema límbico las sensaciones sonaras es diferente al que transporta la información visual.

Cuando es el camino 2 el que resulta dañado pero el camino 3 permanece intacto, el paciente pierde la capacidad de reconocer conscientemente caras (prosopagnosia), pero las reconoce inconscientemente, pues la información puede llegar desde el giro fusiforme hasta la amígdala a través del camino 3. Por ello, el paciente tiene una fuerte reacción emocional al ver a su familiar, aunque no sabe quién es esa persona. Si un estado de disociación como este se prolongara indefinidamente, conduciría antes o después, sugiere Ramachandran (2011), a estados paranoides o fóbicos en esa persona.

Otras veces, debido a alguna enfermedad, los caminos 2 y 3 hacia la amígdala son reforzados por descargas sistemáticas similares a la epilepsia (kindling). Esto puede provocar un síndrome en el que el paciente encuentra que todo el mundo parece extrañamente familiar, y acaba diciendo, por ejemplo, que todo el mundo se parece a un tío suyo. Probablemente, la necesidad de elegir a un familiar concreto deriva de la incoherencia de sentir “familiaridad inconcreta”, y de la pulsión por la coherencia que tiene el cerebro consciente. Del mismo modo, la ansiedad difusa de un hipocondríaco siempre acaba aterrizando, en una especie de racionalización, sobre un órgano o una enfermedad concreta (Ramachandran, 2010).

Esquema simplificado de los caminos visuales y otras áreas relacionadas en los síndromes discutidos en el texto. El camino “How” corresponde al llamado “1” en el texto; el camino “what” corresponde al “2”, y el camino “Old” corresponde al “3”. Tomado de Ramachandran (2011).

El síndrome de Cotard, según Ramachandran (2011), es un caso extremo del síndrome de Capgras. Las personas con síndrome de Cotard suelen perder el interés en el arte y la música, presumiblemente porque tales estímulos no pueden evocarles emociones, como si todas o la mayoría de las vías sensoriales a la amígdala estuvieran totalmente dañadas (a diferencia del síndrome de Capgras, en el que solo el área «facial» en el giro fusiforme está desconectada de la amígdala). Por lo tanto, para un paciente de Cotard, todo el mundo sensorial, no solo su madre y su padre, parecerían irreales, como en un sueño. Por otra parte, las neuronas espejo que le permiten a uno observarse desde el punto de vista de un observador externo podrían estar también dañadas. Tal síndrome es como haber perdido el uno-mismo y haber perdido el mundo, lo más cercano a estar muerto que un cerebro consciente podría sentir. Por ello, la depresión acompaña con frecuencia al síndrome de Cotard. También se explicaría la curiosa indiferencia que tienen tales pacientes ante el dolor. Como un intento desesperado por restablecer la capacidad de sentir algo, ¡cualquier cosa! tales pacientes pueden tratar de infligirse dolor a sí mismos para tratar de recuperar el «anclaje» a sus cuerpos. Si los casos más severos de depresión estuvieran relacionados con esa clase de desconexión completa que sufren los pacientes del Cotard, ello explicaría según Ramachandran el que muchos de ellos se suiciden, extrañamente, tras tomar las primeras dosis de Prozac. El antidepresivo puede darles la mínima autoconfianza necesaria para que el paciente reconozca que su vida y su mundo no tienen significado y que el suicidio es el único escape. En este sentido, Cotard sería un síndrome de apotemnofilia (rechazo de un miembro propio, con deseos de amputarlo) pero de todo el cuerpo, y el suicidio su amputación exitosa.

Este síndrome tan extremo nos sugiere también, en mi opinión, que una parte fundamental de lo que entendemos por sentido (o significado) del mundo consiste en las relaciones emocionales que ese mundo tiene con mi cuerpo, que es lo que hace a las cosas del mundo importantes, interesantes y bellas. Si tal relación emocional desaparece, el mundo y todos sus contenidos, por exóticos y variados que sean, dejan de tener interés y significado para nosotros.

El síndrome de los “ataques de pánico” de unos 40-60 segundos, que afecta a algunos pacientes, se parece a un síndrome de Cotard transitorio acompañado de palpitaciones y del sentimiento de que uno está a punto de morir. Según Ramachandran (2011) pueden explicarse por afectaciones temporales del camino 3, especialmente la amígdala y su flujo de activación a través del hipotálamo, que dispararían una poderosa señal de “huye o lucha” sin que los sentidos detecten nada externo a lo que poder adscribir la fortísima emoción. Por lo que, la necesidad de coherencia del cerebro consciente infiere que la causa del peligro es una afección interna grave. Una ansiedad sin causa es menos tolerable para el cerebro que una ansiedad que pueda ser atribuida a alguna fuente.

Las capacidades cognitivas inconscientes

El conjunto de experiencias vividas, con sus correspondientes resultados prácticos y emocionales, y el aprendizaje estimulado por las simulaciones mentales conscientes, van generando unos hábitos de decisión e incluso un carácter personal. Muchas de las rutinas de decisión aprendidas pueden ser activadas de forma inconsciente en circunstancias similares a las ya vividas o ya experimentadas en la imaginación. El resultado es una capacidad de conocer lo esencial de las situaciones y responder inconscientemente a ellas de forma acorde con nuestros gustos personales, con una rapidez sorprendente.

Esta toma inconsciente de decisiones resulta a veces más eficaz que la deliberación consciente, cuando el tiempo disponible para decidir es limitado. Esto quedó patente en el experimento realizado por el psicólogo Ap Dijksterhuis con grupos de sujetos humanos normales. Les pidió que realizaran decisiones de compra en dos situaciones. En la primera, se les dejaba estudiar con detenimiento el folleto de los artículos durante tres minutos antes de la compra; en la segunda situación, se distraía hábilmente a esos mismos sujetos durante los tres minutos, con el fin de que el individuo no pudiera deliberar de forma consciente. Unas veces el artículo era un objeto trivial de menaje, tal como una tostadora; otras, era un gran compra, tal como un coche o una casa. El objetivo era elegir el mejor artículo para comprarlo. El resultado fue notable: “Las decisiones que se habían tomado sin mediar ninguna deliberación consciente resultaron más satisfactorias en ambas clases de artículos, pero sobre todo en la de las grandes compras. La conclusión aparente es que cuando vamos a comprar un coche o una casa, es preciso conocer al detalle los hechos, pero, una vez conocidos, no hay que preocuparse ni dar más vueltas a las minuciosas comparaciones de ventajas y desventajas posibles. Es mejor lanzarse (…) [Estos resultados] lo que sugieren es que los procesos inconscientes son capaces de cierto razonamiento lógico, mucho más de lo que generalmente se creía, y que este razonamiento, una vez adecuadamente ejercitado a través de la experiencia, puede, cuando el tiempo escasea, llevarnos a tomar decisiones convenientes y ventajosas (…) Dado que no disponemos de todo el tiempo del mundo, en lugar de hacer una gran inversión de tiempo en gigantescos cálculos, vale la pena aprovechar algunos atajos. Y algo que viene muy bien es que, por un lado, los registros emocionales pasados nos serán de utilidad al seguir esos atajos y, por otro, que nuestro inconsciente cognitivo es un buen proveedor de esa clase de registros (…) Ciertas opciones vienen marcadas inconscientemente por medio de una predisposición vinculada a factores emocionales y afectivos previamente adquiridos” (Damasio, 2011, Cap. 11). Ahora bien, si tenemos tiempo suficiente, conviene analizar en detalle la elección ofrecida por nuestro inconsciente, por si hay elementos en la situación presente que invalidan tal elección, basada en experiencias pasadas y pre-juicios adquiridos. El no hacerlo podría llevarnos a, por ejemplo, decisiones injustas en un tribunal, o a decisiones imprudentes en unas elecciones democráticas.

Damasio sugiere también que las pautas cognitivas inconscientes no sólo proceden del aprendizaje y la simulación mental. Habría una serie de disposiciones o inclinaciones de raíz genética, que afectaría al temperamento, que no es uniforme en los humanos ni en los animales superiores. Incluso la relativa mayor frecuencia de comportamientos agresivos en los hombres que en las mujeres podría ser en gran parte derivado de la influencia genética.

La capacidad consciente autorreflexiva y el yo

La actividad de percepción consciente, fenomenológicamente, se percibe como una serie de percepciones alineadas en el tiempo, que cuando tratamos de entenderlas tienden a agruparse juntas en escenas, cada una de las cuales incluye percepciones sensuales externas, percepciones táctiles del cuerpo, percepciones difusas de estados internos del cuerpo, y percepciones de las imágenes imaginarias conceptuales que van siendo generadas por la mente. Todo ello, unido a una sensación vaga de que todas esas imágenes y percepciones forman una unidad en el tiempo como si fueran las experiencias de un testigo único, no de muchos separados o consecutivos. Quizás, ese sentimiento de unidad en el tiempo de las percepciones proceda del hecho de que las componentes interoceptoras de esas percepciones están invariablemente disponibles a la atención atenta, como en un fondo muy poco variable (Damasio). En muchas tradiciones budistas, la forma más simple de consciencia durante la meditación es denominada de hecho presencia plena; y en la tradición Vedanta, a la consciencia meditativa se la llama precisamente el testigo.

La presencia de un testigo puede ser pues una metáfora iluminadora y bastante universal de ese proceso mental, pero sin olvidar que es sólo una metáfora que sustantiviza un proceso complejo interior. La observación fenomenológica (y la científica) no muestra la presencia de ningún testigo físico, ni ningún homúnculo interior al cuerpo o a la mente.

La actividad consciente auto-reflexiva se sustantiviza pues frecuentemente, conceptualizándola como un testigo que percibe todas las demás actividades y estados conscientes, y que tiene una continuidad diacrónica (el mismo testigo presenció escenas pasadas). Llamaremos uno-mismo a esa presencia casi permanente con apariencia de testigo. Con cierta frecuencia, a ese testigo se le añaden conceptos aún más detallados, concibiéndolo como: (i) un observador que tiene cierta personalidad o tendencias a la hora de percibir (lo cual parece una conceptualización metonímica: en realidad, son los estados mentales observados los que pueden tener tendencias discriminables); (ii) tiene cierta personalidad a la hora de sentir y pensar (otra conceptualización metonímica: en realidad, son los estados mentales y corporales observados los que pueden contener sentimientos y pensamientos); (iii) es un agente con voluntad libre para tomar cualquier decisión, que es obedecida inmediatamente por el cuerpo (otra conceptualización metonímica, pues es el cuerpo en realidad el que realiza acciones, a veces consciente y a veces inconscientemente). Llamaremos yo a aquel uno-mismo con estas conceptualizaciones extras añadidas.

El yo y el libre albedrío

La conceptualización tercera de la lista anterior caracteriza al uno mismo como un yo con capacidad agente, y libre albedrío a la hora de decidir el comportamiento del cuerpo. Esa caracterización, además de ser metonímica, choca con las evidencias que nos ofrecen algunos experimentos psico-neurológicos. Por ejemplo, Libet observó neurológicamente el cerebro de sujetos humanos mientras eran invitados a mover libremente cualquier dedo y a indicar el momento en que eran conscientes de la intención de moverlo. En esos experimentos, la aparición del potencial de preparación que antecede siempre a una acción motora humana precedió sistemáticamente a la consciencia del mismo; ocurrió entre 150 y 350 milisegundos antes que la llamada “voluntad consciente”. Libet llegó a la conclusión de que la iniciación cerebral de un acto espontáneo y libremente voluntario puede comenzar inconscientemente, es decir, antes de que haya una consciencia revocable de que la decisión de actuar ya se ha iniciado cerebralmente. Al igual que en la consciencia primaria de un estímulo sensorial, en la consciencia de una intención motora parece necesario que la actividad neuronal subyacente persista previamente durante un período de tiempo considerable, del orden de 100 a 500 ms dentro de un núcleo dinámico de interconexiones neurales. Es después que se ha producido esto cuando algún sistema neural especializado detecta la pauta de “voluntad de iniciar el movimiento de X”. La conclusión notable es que primero nuestro cerebro quiere iniciar inconscientemente una acción, y luego la consciencia auto-reflexiva es consciente de lo que el cerebro quiere, y conceptualiza esa decisión como la decisión de uno-mismo. La consciencia auto-reflexiva sería una especie de sistema neural que informa de modo coherente de lo que nuestro cuerpo está sintiendo y haciendo, de las experiencias de consciencia primaria que nuestro cerebro está generando, y de lo que nuestro cerebro está haciendo; pero no es el disparador último de las decisiones, ni es tampoco el que construye neurológicamente las percepciones, estados mentales o acciones.

Esto es coherente con el hecho evolutivo de que los animales, y nuestros antecesores, con consciencia primaria eran capaces de realizar decisiones motoras antes de ser conscientes de que había algo dentro de ellos que realizaba esa decisiones; sistemas posteriores auto-reflexivos añadieron a esa capacidad la de la consciencia de un invariante interior (o uno-mismo) que se otorgaba la propiedad de fuente de todas las acciones y decisiones. A su vez, sólo los seres con esta nueva clase de consciencia auto-reflexiva empezaron a ser conscientes de la presencia en sus cuerpos de una memoria primaria que ellos mismos están percibiendo.

Según Ramachandran (2011, Cap. 9), la experiencia de libre albedrío deriva del funcionamiento de dos estructuras: la primera es la circunvolución supramarginal en el lado izquierdo del cerebro, que le permite evocar y prever diferentes cursos de acción potenciales. La segunda es el giro cingulado anterior (en la zona periférica del sistema límbico), que te hace desear, y te ayuda a elegir, una acción basada en una jerarquía de valores aprendidos registrados en la corteza prefrontal. Estos valores han sido aprendidos a través de la cultura y de la experiencia individual previa. La corteza prefrontal es aparentemente la sede de pautas de comportamiento aprendidos como el carácter, así como de valores sociales internalizados como la moral, el juicio, o la ética (Ramachandran 2011, Glosario Final).

Según Dennett (2017), la experiencia de la voluntad personal es la manera como la mente muestra el final de sus decisiones motoras al yo, no la decisión misma. Más en general, nuestro punto de vista de primera-persona de nuestras propias mentes es similar al que tenemos de otras mentes (la segunda persona). No percibimos conscientemente toda la complicada maquinaria neural que selecciona entre conceptos, toma decisiones y actúa. Del mismo modo, hablamos para decirnos a nosotros mismos lo que pensamos, y no sólo a terceras personas. El self o yo es como un usuario final de un complejo sistema operativo.

El núcleo dinámico tiene la capacidad, según Edelman, de conectarse con muchas de las rutinas automáticas especializadas mediante puertas de entrada/salida que las une con el núcleo, pero a la vez las separan de la dinámica integrada del núcleo. Estas puertas consistirían en grupos neuronales que interaccionan a la vez con el núcleo y con neuronas que están fuera del núcleo. Por ejemplo, un paseante puede estar caminando en dirección a su casa sin necesidad de atención consciente; pero de repente puede notar la llegada de un autobús detrás de su espalda, y enviar entonces una directiva consciente para correr hacia una parada próxima. Hay siempre disponibles una gran variedad de subrutinas inconscientes cuya activación el núcleo dinámico puede forzar o no. ¿Es esa la base del sentimiento de agencia o libertad de decidir que acompaña a muchas acciones conscientes inmediatas? En cualquier caso, ese sentimiento es bastante ilusorio si se extrapola a todas las decisiones, pues hemos visto que la consciencia sabe lo que va a decidir en los próximos segundos sólo una vez que el cerebro inconsciente ha decidido. Sin embargo, Damasio (2000) sugiere un posible encaje del libre albedrío consciente, y es entenderlo como la capacidad de planificar a largo plazo. Esto es, el conjunto de informaciones conscientes que recibimos del exterior en un momento dado, unido al bagaje de experiencias previas de nuestro cuerpo, nos hacen ver que hay posibles planes de acción (combinaciones posibles encadenadas en el tiempo futuro, de acciones motoras y consecuencias de las acciones) que no conocíamos y, al imaginarlas ahora, observamos que generarían un resultado deseable, sin que el esfuerzo y los efectos indeseables de su imaginaria implementación nos produzcan emociones de rechazo. En ese contexto, el cerebro consciente parece capaz de fomentar unas condiciones ambientales y corporales que favorezcan que el propio cerebro vaya tomando con gran probabilidad las decisiones apropiadas para la realización de los distintos pasos que componen la cadena de acciones del plan mental. La capacidad de deliberación consciente, según Damasio, tiene poco que ver con la capacidad de disparar o controlar al momento las acciones, y está unida más bien a la capacidad de planear con anticipación y fomentar la realización de una clase de acciones que queremos que se realicen. Podemos interpretar que, para conseguirlo, las imágenes mentales que forman parte de esos planes de la imaginación son enviados al sistema límbico como si fueran experiencias reales vividas, para que generen las asociaciones emocionales que harán que las futuras acciones motoras del cuerpo vayan acercándose con gran probabilidad a las etapas planeadas. De este modo, los actos motores componentes (activados por el arco cingulado anterior) se realizarán como si hubieran sido reforzados por experiencias gratificantes ya vividas, aunque en realidad el reforzamiento lo están produciendo experiencias imaginadas.

Un músico de una orquesta en muchos momentos interpreta la música automáticamente y sin necesidad de atención consciente; pero de repente puede notar un cambio de ritmo inesperado en la batuta o en otros compañeros de orquesta, y enviar entonces una directiva consciente para aumentar la velocidad de los dedos que activan las teclas de su instrumento. El que una directiva de este tipo tenga tan alta probabilidad de ser obedecida, interpretamos que se debe a lo siguiente: la percepción sonora y visual de la aceleración repentina del ritmo de los otros músicos produce rápidamente la imagen mental de las consecuencias que tendría el que uno mantuviera el mismo ritmo de ejecución ajeno al de la orquesta; esta imagen mental, recibida en el sistema límbico genera una reacción emocional de miedo y vergüenza, como si la escena estuviera realmente ocurriendo, lo cual estimula rápidamente la activación de mapas motores correctores que aceleran la frecuencia de pulsación del propio instrumento.

Las imágenes mentales, como simuladoras de realidad que son, pueden tener pues efectos emocionales similares a la realidad misma, y pueden ser utilizadas para construir planes de acción. Pero también para aumentar rápidamente la probabilidad de que nuestros sistemas inconscientes especializados reaccionen como lo harían ante una escena real. Esto proporciona una enorme variedad de conductas y formas de adaptarse nuevas a los animales capaces de simular escenas con la mente; mucho más aún si dentro de estas escenas son capaces de incluir al propio cuerpo con sus emociones imaginadas reaccionando al entorno imaginado.

Así, en lugar de seguir pensando en que hay un yo ahí dentro que decide como una especie de dictador del propio cuerpo, sería más realista concebir la toma de decisiones consciente como un proceso cerebral colectivo. El cerebro funciona utilizando rutinas inconscientes automáticas aprendidas en su experiencia pasada siempre que los rasgos significativos del entorno son familiares o habituales. Pero genera rápidamente un núcleo dinámico consciente cuando percibe algún factor repentino en la situación que la convierte en no habitual. Tras focalizar la atención sobre el factor novedoso, el núcleo dinámico utiliza su experiencia y conocimiento simbólico previo, acumulado en sus redes neurales, para generar una realidad virtual de las consecuencias que probablemente derivarán de ese factor nuevo.

Caso 1: Si la consecuencia imaginada del factor nuevo es única con gran verosimilitud, y esa consecuencia imaginada provoca una reacción emocional clara (positiva o negativa), y el (acelerar o evitar) el nuevo escenario virtual requiere acciones motoras similares a otras ya experimentadas o simuladas: En este caso, los núcleos límbicos pondrán automáticamente en acción los sistemas motores apropiados para adaptarse (acelerar o evitar la llegada de la consecuencia) de forma inconsciente. El etiquetamiento conceptual y verbal de la actividad cerebral asociará la situación a un concepto del tipo “se va a resolver” (en un cerebro budista) ó “(yo) lo voy a resolver” (en un cerebro occidental), generalmente una fracción de segundo después de que se haya empezado a resolver.

Caso 2. Si la consecuencia imaginada del factor nuevo es única con gran verosimilitud, pero no provoca sino respuestas emocionales de indiferencia, el núcleo dinámico “pasará por alto” el nuevo escenario, los rituales inconscientes que estaban en curso se dejarán proseguir, y la atención consciente volverá a relajarse. El etiquetamiento conceptual y verbal de la actividad cerebral será algo como “no pasa nada”; “seguimos” ó “sigo haciendo”.

Caso 3. Si la consecuencia imaginada del factor nuevo es única con gran verosimilitud, provoca una reacción emocional clara de miedo (en lo sucesivo consideraremos sólo reacciones emocionales de rechazo) pero no hay rituales motores familiares para evitarla, el sistema límbico reaccionará dependiendo del grado de miedo y urgencia activado.

- Si el miedo es extremo (por ejemplo, ha aparecido un león y está demasiado cerca para intentar llegar a un refugio) el sistema límbico paralizará todas las rutinas motoras que puedan activar los músculos rojos, y se inhibirá la sensibilidad táctil y la subjetividad. El cuerpo se percibirá objetivamente, como desde fuera. Pero el cerebro permanecerá visualmente atento por si algún factor nuevo cambiara la situación.

- Si el miedo es sólo leve o moderado, el sistema límbico activará a la imaginación para que explore acciones nuevas que pudieran impedir o mitigar la consecuencia temida (v.g. buscar nueva información relevante al problema; buscar la ayuda de ciertas personas; etc.). Esto puede iniciar una cadena de intercambios entre ideas de la imaginación y nuevas reacciones emocionales del sistema límbico, proceso interactivo que a veces es consciente y otras inconsciente, hasta ir acotando un conjunto factible de soluciones definitivas óptimas (cuya conceptualización sería algo como: “Ahá! ¡Lo encontré!”), o solamente mitigadoras (“trataré de llevarlo lo mejor posible”).

Caso 4. Si las consecuencias del factor nuevo son previsiblemente diversas, dependiendo de otros factores que podrían intervenir, el núcleo dinámico tratará de representar mentalmente todos los escenarios que son posibles, y las correspondientes reacciones emocionales límbicas comenzarán activando las rutinas motoras encaminadas a evitar primero los peores escenarios posibles; esto tendemos a hacerlo conscientemente cuando la carga emocional negativa es intensa. Prevenidas así o mitigadas, supuestamente, las consecuencias peores, la atención consciente se puede encontrar con dos escenarios posibles finales que desencadenan emociones moderadamente negativas pero de intensidad parecida. En esta situación, cualquier acción motora que se encamine a evitar el escenario X, o bien el escenario Y, o bien ambos a la vez, será sentida como deseable, de modo que las reacciones límbicas no desequilibrarán el impasse en ninguna dirección concreta. Es de suponer que en tal situación, un estímulo sensorial insignificante, o incluso el estado homeostático del cuerpo en ese momento, pueden desequilibrar el impasse, facilitando que se inicien primero las acciones, por ejemplo, que conducen a evitar el escenario X. Las áreas semánticas más altas del córtex, las que generan las conceptualizaciones más abstractas, no-verbales (en el córtex frontal y áreas asociativas) y verbales (porción triangular izquierda del giro frontal inferior, surco intraparietal, giro temporal inferior, giro temporal medio posterior, giro supramarginal y área de Wernicke, según Montefinese, 2019), generarán entonces un concepto del tipo: “(yo) he decidido hacer HX para evitar X” (en un cerebro occidental), ó “(el cuerpo) hace HX para evitar X” (en un cerebro budista).

La capacidad de soportar la incertidumbre más tiempo, y la voluntad de perseverar en el análisis consciente de posibilidades cada vez más detalladas (como hace el jugador de ajedrez) son capacidades que se pueden entrenar. O, al menos, son capacidades que se han podido entrenar si el entrenar capacidades como estas, sin un beneficio inmediato, ha entrado en lo percibido como deseable a nuestro carácter.

Si una persona ha estado entrenando estas capacidades durante años, el día que el entorno cambie ofreciendo futuros inciertos, se encontrará con la capacidad de explorar conscientemente planes más detallados y numerosos que enviar a su sistema emocional. Su proceso de optimización de la elección final será más largo, pero probablemente el plan final elegido estará más ajustado a la complejidad de la situación, y tendrá menores riesgos de grandes sustos futuros.

La persona que no haya entrenado esas capacidades contará con una voluntad laxa, tenderá a conformarse con lugares comunes y refranes, antes que con un análisis detallado de lo específico de la situación. Las dos clases de personas que comentamos sienten tener “libre albedrío”, y lo tienen en el sentido analizado más arriba: cuando su análisis les ha llevado a planes alternativos que tienen un atractivo emocional muy similar, cualquiera de ellos es elegido, en respuesta a factores insignificantes no conscientes, externos o internos, y en ese momento el yo es consciente de haber elegido voluntaria y libremente. Pero hay una diferencia cuantitativa entre la libertad de una y otra persona, y es que el menú de alternativas entre las que el primero de ellos ha elegido ha sido probablemente mucho mayor que el menú de alternativas del segundo.

Como corolario de esta sección, podemos decir que la intuición de Schöpenhauer sobre la determinación del libre albedrío por el carácter y las emociones es coherente con el conocimiento actual de la neurología. Esa intuición es especialmente correcta para las decisiones inmediatas de la voluntad, a unos segundos vista, que se opongan frontalmente con las emociones que la decisión va a despertar, fundamentadas en nuestra experiencia previa y nuestro carácter. Para los planes de acción y entrenamiento personal que formulamos a largo plazo, podríamos decir que no hay ni determinación ni libre albedrío. Los planes conscientes de acción van trazando vías nuevas para la exploración emocional, y van familiarizando a las emociones con tipos de escenario que unos años o meses atrás habrían provocado miedo automático al propio sistema límbico, o éste habría rechazado por el esfuerzo que requieren, al no saber que ofrecía satisfacciones probables. Esta apertura de vías emocionalmente posibles a largo plazo corre a cargo de intuiciones conscientes, curiosidad, oportunidades afortunadas ofrecidas por el entorno, y la voluntad consciente de exploración y juego. Este conjunto, no es exactamente lo que algunos conciben como “libre albedrío”, pero en mi opinión es el conjunto de factores realistas que más cerca están de este concepto. Una sociedad verdaderamente humana debería dar a todos los humanos un ambiente lo suficientemente estimulante como para que desarrolle un carácter explorador, analítico y deliberativo (abierto a considerar dentro de sus planes las experiencias de otros). Dotados de tal carácter, la decisión final motora a corto plazo será siempre emocional, pero (en las situaciones que no sean de emergencia) se producirá entre alternativas producto de un proceso largo de análisis, por lo que serán decisiones “muy razonadas”.

La mayor libertad que nos es accesible es la de haber tenido la suerte de haber sido estimulados con frecuencia, por ambientes, sugerencias culturales y curiosidad, hacia decisiones que nos facilitaron el cultivar un carácter observador, analítico y deliberativo; y haber contado con la salud y energía suficientes como para explorar esos estímulos, pudiendo haber permanecido actuando automáticamente.

El carácter cultivado a lo largo de los años es el efecto de decisiones personales previas, hechas muchas veces por intuición, sugerencias sociales externas, e inclinaciones temperamentales en gran parte congénitas. El carácter incluye tendencias cognitivas que son diferentes en distintas personas. Por ejemplo, las personalidades creativas tienden a buscar metáforas nuevas para entender situaciones nuevas (véase Las metáforas y la construcción imaginaria de la realidad). Las personalidades ordenadas y sistemáticas tienden a utilizar las metáforas conocidas. Esto es aprovechado por los partidos conservadores, por ejemplo, para proponer marcos metafóricos populares unidos a ideas tradicionalistas a las “personas de orden”, como parte de su oferta electoral (Lakoff 2007). Las personalidades que han tenido una formación intelectual escasa tienden a utilizar la metonimia, en el sentido de que tienden a confundir el estereotipo con la categoría que lo engloba, y el efecto con la causa. Por ejemplo, si en su infancia han vivido en una familia con padre, madre e hijos, tienden a pensar que esa familia prototípica es natural, y que otras clases de familia son aberraciones. O, tienden a pensar que todos los catalanes son tacaños, todos los negros son poco inteligentes, y todos los gitanos son de poco fiar. También, que toda pareja debe ser como la pareja ideal que tienen en su mente. O, colocando efectos en la posición de causas: no es que los inmigrantes tengan que aceptar salarios miserables o el “top manta” por estar en situación límite, sino que “vienen a robarnos a los españoles”; no es que los inmigrantes reciban salarios miserables y por eso no tienen agua caliente en sus pisos, sino que “son sucios”. El recurso metonímico requiere de habilidades cognitivas muy elementales y extendidas, por lo cual es muy utilizado por grupos de ultraderecha para manipular a los sectores menos analíticos de la población.

Mapa multi-modal y problemas en la identificación del propio cuerpo

Las sensaciones táctiles de la piel, los músculos y los tendones, se proyectan hasta el cortex somatosensorial primario (S1) y secundario (S2), justo detrás del giro postcentral. En ambas áreas hay un mapa topográfico del cuerpo. Desde allí, se envía información somatosensorial hasta el lóbulo parietal superior (SPL), donde se combina con información del equilibrio procedente del oído interno y con información visual sobre la posición de las extremidades. Estas informaciones juntas construyen una imagen a tiempo real del propio cuerpo en el SPL. Es probable que esta estructura también tenga organizada la información topográficamente.

Fig. Giro postcentral (en amarillo)

Esta mapa podría ya venir constituido al nacer, como vimos en el post Las bases neurológicas del reconocimiento de los cuerpos y la imitación. Pero si, por alguna patología, un miembro particular del cuerpo no es representado en ese mapa interno, el resultado es previsiblemente una sensación de extrañeza ante la visión del propio miembro, del cual recibimos sensaciones táctiles que el cerebro no sabe colocar en su propio mapa corporal. Pero ese es el síntoma que sufren los pacientes con apotemnofilia: sentimiento del miembro como extraño al propio cuerpo, de “sobrepresencia” del miembro, y deseo de amputárselo, unido a veces con atracción erótica hacia parejas con ese miembro amputado. El sentimiento de aversión vendría de la incoherencia citada, y según Ramachandran (2011, Cap.9) se produciría físicamente en la ínsula del hemisferio derecho, que recibe señales de S2 y envía información a la amígdala, la cual envía señales de empatía o antipatía. En cuanto a la atracción sexual hacia parejas amputadas, podría derivar de que el atractivo sexual de otra persona es dictada en parte por la forma de la imagen corporal que tenemos de nosotros mismos. De ahí que los humanos prefieran a otros humanos como pareja, y los cuervos a otros cuervos.

La pulsión por la coherencia narrativa del hemisferio izquierdo y la información derecha

La información que llega a través de los sentidos normalmente se fusiona con recuerdos preexistentes para crear un sistema de creencias sobre uno y el mundo. Ramachandran (2011, cap. 9) sugiere que este sistema de creencias internamente consistente está construido principalmente por el hemisferio izquierdo. Si hay una pequeña pieza de información anómala que no se ajusta a su sistema de creencias, el hemisferio izquierdo trata de suavizar la discrepancia para preservar la coherencia y la estabilidad del comportamiento. Esta tendencia es compensada, según este autor, por el hemisferio derecho, que toma una perspectiva más alocéntrica (desde fuera) de uno mismo, revisa la narrativa coherente que fabrica el ego-centrado hemisferio derecho, y detecta informaciones que éste ha desechado y son significativas. Muchos de los pacientes que sufren trombos en el hemisferio derecho, con parálisis del lado izquierdo de su cuerpo, niegan que sufran parálisis alguna (anasognosia), o afirman que el miembro paralizado no les pertenece. Esto podría derivar de la inactividad de la labor crítica del hemisferio derecho sobre las construcciones quasi-racionales y racionalizaciones del hemisferio hablante (izquierdo). En un caso extremo de anasognosia, una paciente de Ramachandran, tras afirmar una y otra vez que ella podía usar su brazo izquierdo (paralizado), tras requerírsele que se tocara con él la nariz, usó el brazo derecho para tomar la mano izquierda y tocarse la nariz (!). Alguna parte de su cerebro captaba pues que el brazo izquierdo estaba en realidad paralizado, pero esa información no llegaba a su consciencia.

Esta pulsión del hemisferio izquierdo por crear una narrativa lo más coherente posible entre sus impulsos (el ello de Freud) sus experiencias, sus recuerdos y sus valores adquiridos (al que podríamos llamar el superego) durante todo el tiempo, podríamos identificarla con el yo freudiano. El hemisferio izquierdo parece usar incluso los mecanismos de defensa, que identificó Anna Freud, para sostener esa coherencia. Ramachandran da ejemplos de cada uno de ellos sacados de su experiencia clínica:

- Negación total. “Mi brazo no está paralizado”.

- Racionalización. “¿Por qué no está usted moviendo su mano izquierda tal como le pedí?” Respuesta: “Soy un oficial del ejército, Doctor. No recibo órdenes”, o bien: “Los médicos estudiantes han estado probándome todo el día. Estoy cansado”, o bien: “Tengo artritis grave en mi brazo; es demasiado doloroso moverlo”.

- Confabulación. “Yo puedo ver moverse a mi mano, Doctor. Está a una pulgada de su nariz”.

- Formación reactiva (exageración en sentido contrario a la verdad inaceptable). “¿Cuánto puede usted levantar esa mesa del suelo con su mano derecha?” “Sobre una pulgada”. “¿Y con la mano izquierda?” “Dos pulgadas”.

- Proyección. “El brazo [paralizado] pertenece a mi madre”.

- Intelectualización. Casos en que familiares del paciente, incapaces de afrontar la probable muerte del mismo, tratan la enfermedad como un reto puramente intelectual o científico.

- Represión. La mayoría de los pacientes de anasognosia se recuperan de este síndrome después de varios días. Uno de ellos insistió durante nueve días en que su brazo paralizado “funcionaba bien”. A la misma pregunta, el décimo día respondió: “Mi brazo izquierdo está paralizado”. “¿Cuánto tiempo ha estado paralizado?” Respuesta: “¡Cómo! Pues durante los varios días que ha estado usted viéndome”. “¿Qué me dijo usted cuando le pregunté por su brazo ayer?” “Le dije que estaba paralizado, por supuesto”. Claramente, el paciente estaba reprimiendo ahora el recuerdo de sus negaciones.

Ramachandran está pues de acuerdo con Daniel Dennett en que más que una entidad real, “el yo es más parecido conceptualmente a un ‘centro de gravedad’ de un objeto complicado, con sus muchos vectores intersectándose en un punto imaginario único”.

Memoria y continuidad biográfica

De acuerdo con Ramachandran (2011), los psicólogos distinguen tres clases de memoria: a) memoria procedural: Capacidad de reproducir habilidades aprendidas, como caminar, atarte los zapatos, o montar en bicicleta. Tales memorias son recuperadas instantáneamente cuando la ocasión lo requiere, sin esfuerzo consciente. Es una memoria común a muchos invertebrados y todos los vertebrados. B) Memoria semántica: El propio conocimiento factual de los objetos y eventos del mundo. Por ejemplo, uno sabe que las berenjenas tienen la piel violeta, o que el sol amanece cerca del este. Sería algo similar a un diccionario o a una enciclopedia. Esta clase de memoria la tienen también otros animales. C) Memoria episódica: son los recuerdos de escenas que uno contempló personalmente, que no necesariamente han sido contempladas por otras personas, y que pueden ser “recordadas”. Sería algo similar a un diario. Esta clase de memoria es específicamente humana. El uno-mismo se conceptualiza como único (no diverso) porque no hay ningún otro sujeto que afirme recordar todos los episodios que uno recuerda.

La pulsión a ordenar todas las escenas percibidas por la consciencia primaria en el tiempo, aproximadamente según su orden de aparición, parece ser exclusiva de los seres humanos, y es lo que construye la memoria episódica y la propia biografía. Y aún más exclusivamente humana es la capacidad de imaginar escenas futuras posibles y planes de acción futura, que parecen requerir lóbulos frontales especializados como los del cerebro humano.

Ramachandran (2011) cita un extraño síndrome (descrito por Elden Tulving) en el que el paciente sufre daños en partes de sus lóbulos frontal y temporal y, como consecuencia, pierde toda su memoria episódica y se vuelve incapaz de generar nueva. En esa situación, el paciente no tenía auto-biografía alguna que recordar y, sin embargo, parecía conservar un sí-mismo y un conocimiento factual y semántico normales, que le permitían una interacción normal con los otros y con las cosas, siempre en el presente. Esto sugiere que la auto-biografía es una componente que enriquece al uno-mismo, pero no es indispensable para su funcionamiento.

La cultura como una homeostasis generalizada

Para Damasio (2011), la consciencia autorreflexiva posibilita la construcción y realización de planes colectivos, que constituyen una forma extendida del gran fin de los organismos vivos inconscientes, que es el mantenimiento y promoción de la propia vida y su homeostasis. Permite buscar, no sólo la homeostasis presente, sino el bienestar imaginado, anticipado, discutido grupalmente. Se trata de una homeostasis sociocultural que trata de que la forma social de vivir sea sostenible. Para lo cual, inventa la cooperación, el intercambio, las jerarquías, el comunitarismo, la escritura, las leyes, los roles sociales, los mitos, las técnicas, los saberes mágicos, religiosos y científicos, las artes… Muchas de estas instituciones y sistemas logran mejorar la estabilidad de las relaciones humanas; otras mejoran el bienestar de grandes grupos humanos. Por lo cual, la cultura se puede concebir como una generalización colectiva de la tendencia a asegurar la homeostasis corporal que tienen los sistemas nerviosos animales. De ahí que el funcionalismo de Malinowsky y otros antropólogos tenga cierta justificación biológica. Todas las culturas tienen instituciones (primarias) que resuelven las necesidades biológicas humanas, instituciones secundarias, que resuelven los problemas administrativos, políticos y de orden social, e instituciones terciarias, que cuidan de la reproducción y estabilidad de las instituciones secundarias y primarias mediante visiones del mundo, religiones, marcos metafóricos, saberes científicos, magia, e ideologías (véase el post Ensamblajes socio-técnicos y complejidad social). Sin embargo, culturas diferentes usan visiones del mundo, marcos metafóricos (véase post Las metáforas y la construcción imaginaria de la realidad) e ideologías (Las ideologías y la sociología del conocimiento) diferentes para fomentar la vida colectiva.

La sustantivización y reificación de la capacidad consciente humana, hasta crear un agente interior imaginario (el yo) es un paso metafórico y metonímico que culturas más observadoras que la occidental recomiendan no dar (culturas o subculturas como la taoísta, la budista y la vedanta). La observación introspectiva simplificada que permite la meditación muestra simplemente que el cuerpo hace lo que sabe hacer en cada momento, sin que haya ningún agente “cabalgando encima de él” o dándole órdenes. Pero esa observación tan ecuánime choca, en las sociedades jerarquizadas, con unas demandas y una tecnología de dominación que vienen de fuera: “¡obedece o te mato!”, “¡obedece o atente a las consecuencias!”. Una sociedad en que hay minorías importantes que desean esa forma de orden induce al cerebro a crear una especie de gendarme interior que se especializa en vigilar el comportamiento del cuerpo propio para que no se desvíe demasiado de unas demandas exteriores, con el fin de evitar daños mayores. El yo racional que inventaron los griegos y desarrollaron los cristianos es, por ejemplo, un sistema que antepone el cálculo de costes y beneficios que tienen las acciones personales por encima de las otras pulsiones y capacidades corporales (véase La dominación urbano-estatal y su imaginario y Tensión entre las dos formas occidentales de conocer el mundo).

El gran poder de sugestión que tiene la educación escolar y las costumbres compartidas por muchos, convierten esas demandas externas en valores deseables y objetivos a perseguir razonados y racionalizados como sistemas de valores propios en muchos cerebros. Entonces aparecen como sistemas de valores internos, como sistemas conceptuales asociados a los otros mapas y memorias cerebrales (de hecho, se piensa que son memorizados en el córtex prefrontal). Es lo que Freud denominó el super-yo.

El principio jerárquico de ordenación social, que ordena la sociedad en clases sociales y pirámides de autoridad (y que convive en paralelo, como subraya Graeber, con el principio comunista que se da entre los cercanos, y con el principio de reciprocidad que se da entre los ciudadanos) se empieza a volver importante en ciertos escenarios ecológicos y sociales. En Ensamblajes socio-técnicos y complejidad social analizamos las condiciones bajo las cuales la mayoría social aceptó abandonar el comunitarismo igualitario para entrar en sistemas sociales con jerarquías, que luego se volvieron irreversibles. Estas sociedades jerárquicas fueron un gran estímulo para la generación de la clase de yo que concebimos tener los occidentales, conceptualizado como un amo, con un fuerte componente de super-yo, y en constante vigilancia del comportamiento del cuerpo. Esa clase de uno-mismo no se conforma con observar ecuánimemente lo que hace el cuerpo y su cerebro. Debe dominar su cuerpo y sus actos, aunque en el fondo sabe que no lo hace, porque no existe como agente. Pero las instituciones sociales deben poder castigarlo si se sale del juego del amo y del esclavo.

Referencias

Damasio, Antonio (2010). Y el cerebro creó al hombre. Grupo Planeta.

Dennett, Daniel C . (2017). From bacteria to Bach and back: the evolution of minds. W. W. Norton & Company. Edición de Kindle.

Edelman, Gerald and Tononi, Giulio (2000). A Universe of Consciousness: How Matter Becomes Imagination. Ingram Publisher Services, US.

Lakoff G. (2007). No pienses en un elefante. Editorial Complutense, Madrid.

Montefinese M. (2019). Semantic representation of abstract and concrete words: a mini-review of neural evidence. Journal of Neurophysiology, 2019. https://doi.org/10.1152/jn.00065.2019

Ramachandran, V. S . (2011). The Tell-Tale Brain. W. W. Norton & Company .

![figura[1]y fondo](https://entenderelmundocom.files.wordpress.com/2020/04/figura1y-fondo.jpg?w=508&h=338)